李善友:DeepSeek,是国运的AI支点

2025年4月25日,2025年李善友开年大课暨混沌·AI创新院开学典礼正式开讲。

Day1的主题是"AI的进击",在上午的大课中,教授动情表示:DeepSeek,将是国运的AI支点。

以下是李善友教授大课的笔记内容。

讲者 |李善友

我相信未来的20年,必然是AI在中国的黄金20年。

其实在大课开始前,我们同事问我:教授你为这堂课,做了多长时间的准备?

我想:这个准备,如果从长来说可能是十年,往短里说可能是18个月。

所以:18个月以来,我一直在思考,今天这个时代命题是什么?混沌要呼应什么样的命题?

我要把最大公约数的那个命题,像旗帜一样举出来,跟所有同学们去呼应。

这个命题究竟是什么?

我一直在思考。

今天,就是我对这个思考的一次揭晓,我们的题目叫——

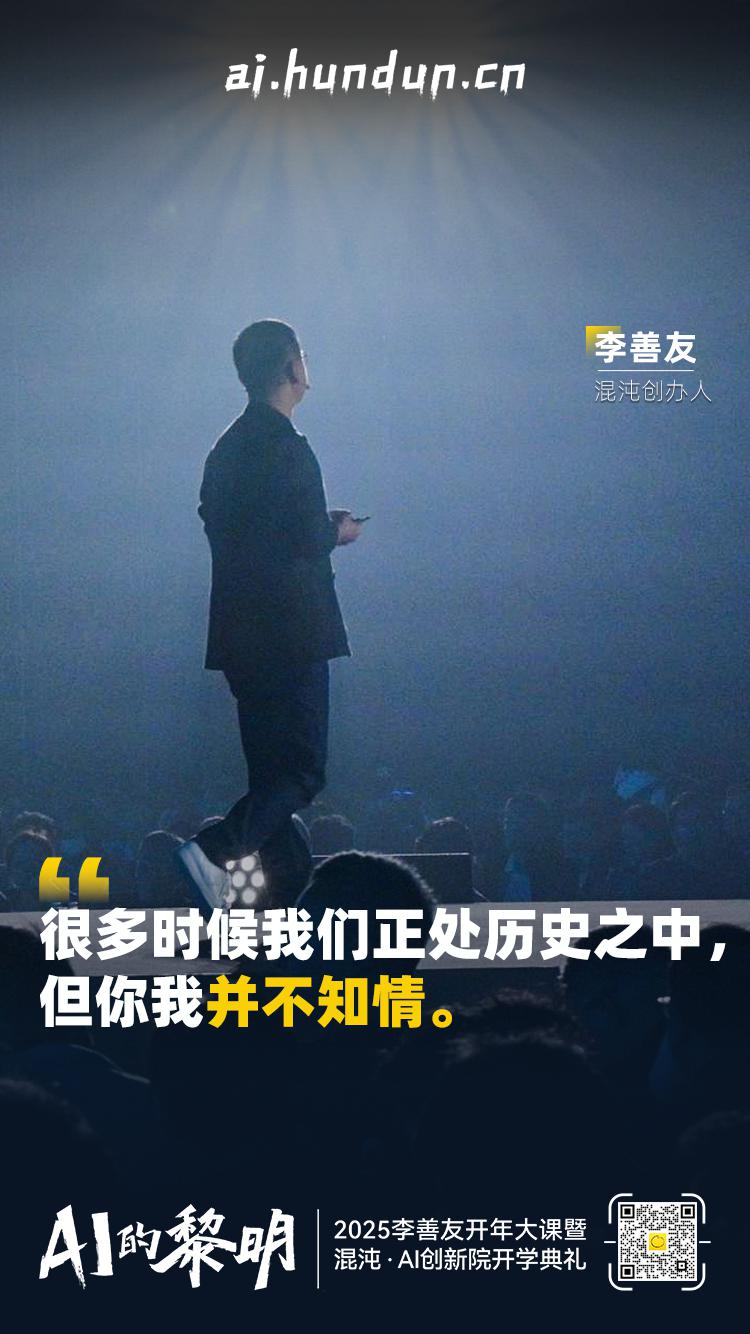

AI的黎明

我觉得我们就在历史当中,但是我们并不自知。

2015年OpenAI成立,它起初是一家非营利实验室:早期他们想做一个开源的、安全的人工智能。

最先发起这个倡议的人是马斯克,他找到了今天OpenAI的CEO奥特曼,一起联手从谷歌挖来了Ilya,去做OpenAI的首席科学家。

因为马斯克看见了一件事情,谷歌把之前最领先的AI实验室DeepMind给收购了。

马斯克心中有一个巨大的隐忧——AI比核武器更具威胁,任由AI发展下去,最终AI一定反过来控制人类,甚至会毁灭人类。

其实我认为,OpenAI是这一轮AI革命的先驱。

我觉得全世界的人,都应该向AI革命的先驱OpenAI致敬,因为它把人工智能从理念和理论,去变成模型、变成产品、变成应用。

这里我想讲一下,OpenAI是如何为AI来建模的?

什么叫建模?混沌看任何事情的时候,不会说这个事儿是什么,我们的"第一问"就会问这个事的"一"是什么?

这句话,等同于在追问这件事情的本质是什么?

所以,今天我想提供一种非常简单的建模方式,用这个建模方式作为一个语言体系,我为大家一点一点梳理AI背后的本质到底是什么?

这个模型我称为XY维度建模法。

我想用X轴和Y轴的二维结构,来看OpenAI如何为整个行业建模,陪大家探索AI背后的本质。

我在这里重申一次:为AI建模,不是OpenAI独立完成的,它是几代人、整个生态一次又一次迭代的结果。

接下来我会讲五个关键节点,结合XY维度建模法前,从基础的科研到技术,到产品,到商业化,来让你理解OpenAI是如何为AI来建模的。

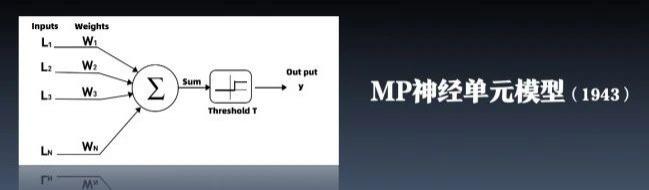

第一个关键节点:1943年,MP神经单元模型

人工智能有很多流派,简单来说有两大流派。

第一个流派叫符号主义,基于人类的规则来做人工智能。

就是教人工智能学习人类的方式、像人类一样思考。

另外一派是少数派,是最不被认同的非主流者,叫连接主义。

他们认为,凭什么让人工智能像人一样去思考呢?

这一派的特点是"不干预",以翻译为例,缺点是即使AI翻译出来了,你也不理解它是如何翻译出来的。

这两派竞争了很多年,几乎没有人相信第二派。

在第一个节点,我要致敬的人物是McCulloch和Pitts两位教授,两人可以称为神经网络之父。

我们今天之所以会有人工智能,是因为80年前,这对像父子般的教授联手为神经元建模。

1943年,两人用数学的方式建立了MP神经单元模型。

MP神经单元模型非常简洁,分三部分:左边是输入,右边是输出,中间是隐藏层。

如果X代表输入,Y代表输出,这个模型会发生一件非常有意思的事,当X在某个数字之前的时候,Y一直等于0。

而当X达到某一个数值后,Y突然就变成了1,这就是——

涌现。

而中间层就是人工智能的灵魂,它像黑盒子一样,在人工智能里面存在着。

另外如果今天有一个词你要带回去,我希望你把涌现带回去。

涌现是我们今天未解的一个宇宙之谜,我相信它是AI的秘密,但反过来说,也是我们在AI时代存活下去的一个机制。

第二个关键节点:1986年,深度学习

第二个节点,我要致敬的人物是Hinton,被称为深度学习之父,而且在去年拿到了诺贝尔奖。

如果没有他对神经网络路线的探索,后面的一切都不会发生。

Hinton从小就相信:人工智能应该学习人类大脑神经网络,能够自发产出智能。

当他毕业的时候,他仍然坚持自己的道路,但他的导师不相信,因为从理论上来看,这件事不可行,甚至会成为笑话。

面对众多的质疑,他辗转去了美国好几个学校做博士后、教授助理、副教授等,但始终难以施展拳脚。

直到后来他到了加拿大,幸运的是,最终成功了。

1986年,他提出了反向传播算法,它可以反向回来校验结果跟目标之间的差距。

今天,反向传播算法是深度学习的核心技术之一,也是当前大模型训练的基础方法。

第三个关键节点:2012年,AlexNet

斯坦福大学有一个华人女教授叫李飞飞,她发现小孩子可以识别猫和狗,但当时的人工智能无法做到。

于是她做了一个ImageNet大赛,让全世界所有的AI来识别猫和狗。

而Hinton还有两个学生非常有名,一个是Alex,另一个是Ilya。

三个人用反向传播算法做了一个模型——

AlexNet。

直到2012年,AlexNet模型在大赛当中的错误率是15%,而前一年的冠军是26%。

这个结果震惊了业界,因为这说明深度学习不仅理论上可行,在实际运用时还能一鸣惊人。

从那一天开始,人工智能领域变天了。

因为大多数人是看见才会相信,AlexNet的意义非凡。

它证明了:只要算力足够大,只要数据足够多,神经网络一定可以超越人类视觉。

这就又到了我提到的:XY维度建模法。

如果AlexNet的X轴是多层神经网络(特有的叫卷积神经网络),那么它的Y轴有两个要素出来——

一个是数据的规模,ImageNet大赛有上百万张图片供模型去训练。

另一个则是GPU,Hinton师徒三人第一次把GPU用在人工智能领域,因为GPU可以并行运算。

而直到两年以后,黄仁勋才意识到GPU的黄金时代来了。

第四个关键节点:2017年,Transformer

2017年6月,8位谷歌的科学家、工程师发表了一篇论文叫做《Attention is all You Need》。

这篇论文为今天AI的形态扎下了根基,就像是在工业革命里人类发明内燃机一样,人类找到了智能革命的内燃机。

这个内燃机就是论文中提出的Transformer,这是一种基于自注意力机制的神经网络架构。

总而言之,Transformer创造了一个巨大的一个武器,一种极大的力量。

这个力量并不是自然界存在的力量,而是人类发现的一个计算里面的力量存在。

第五个关键节点:2020年,GPT-3横空出世

Transformer这篇论文刚发布的时候,谷歌还没有人能挖掘出它更深层次的意义,只把它运用在机器翻译上。

而Hinton的学生、OpenAI首席科学家Ilya,相信Transformer可以用在所有的通用数据、通用语言里。

在Transformer的基础上,Ilya加上了Scaling Law 的维度,让GPT成为了可能。

Scaling law是大语言模型里的一个自然法则,简单理解就是规模越大,性能越强,大力出神迹。

而大力包括三部分:第一是算法的规模,也就是模型参数的规模;第二是数据量的规模;第三是GPU卡数的规模。

这三个规模越大,去做预训练,就越可以让智能涌现。

通过不断地训练,人工智能体的智商不断提高,它就可以帮人类干活了。

Ilya是全世界第一个理解这件事情的人。

那么,GPT是什么意思呢?它的全称是Generative Pre-trained Transformer,也就是生成式预训练变换模型。

它最重要的的功能是生成连贯的文本内容,而不仅仅是分析或分类现有数据。

我们来看一组惊人的数据——

2018年,GPT-1,1.17亿参数,没跑出什么来。

2019年,GPT-2,15亿参数,也就那么回事。

2020年,GPT-3,1750亿参数,智能涌现了。

GPT-3涌现出两个能力——

第一个能力,是不需要训练就知道专业领域的东西了。

第二个能力,是突然能理解了上下文的推理了。

所以,Ilya可以称为GPT之父。

既然提到"GPT之父",这里说个题外话,OpenAI之父该是马斯克的,但后来马斯克离开了。

奥特曼加入了OpenAI去做CEO,所以最后是他把公司做出来的。

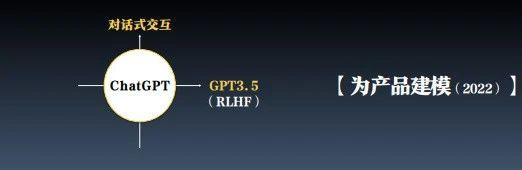

当GPT-3出现之后,OpenAI的开发人员设想:能不能把对话的交互界面当成产品界面?

于是,就有了我们今天用的产品ChatGPT,它倡导用户跟它聊天。

到这一步的时候,技术变成了产品。

2022年11月30日,OpenAI发布ChatGPT-3.5,五天时间用户过百万,2个月用户过亿。

它成为史上增长最快的消费级应用,超过了之前的谷歌。

我们可以用一个模型来总结——

OpenAI 将两个关键要素重新组合:

一个是Transformer,一个是Scaling Law,这两个要素在模型维度上的结合,形成了大语言模型。

这个大语言模型所推出的技术,就叫做GPT。

如果用混沌理论中的"一"思维模型来看,大家看到的可能是GPT的功能,而它背后的"一"就是大语言模型。

OpenAI的能力不仅限于此。

2023年9月13日,他们发布了新的推理模型o1。在数据竞赛中,其准确率从GPT的13%直接跃升至83%.

o1模型不仅能解数学题、逻辑题,还能编写代码。

从ChatGPT到o1,这种进步速度,相当于人类思维从系统一(直觉反应)跃迁到系统二(理性思考),把原需10年的AGI进程缩短到两三年。

而真正的理性不在于给出答案,而在于中间的推理过程:而o1实现了这个推理能力。

我记得人们一直在讨论:AGI什么时候能实现?

有人预测可能需要十年。

如今,业界对AI的预测普遍乐观。

我看到最乐观的预测,是认为2026年底就能实现AGI,而最悲观的预测也是不超过2029年底。

当然,面对OpenAI,我们要站在人类的角度,去审视这一技术革命的贡献。

但毕竟我们生活在这片土地上,我们毕竟是中国人,相信各位心中都萦绕着一个问题——

中国AI,路在何方?

我想跟你分享一句话——

一个人所遇到的最美好的事,就是与时代共舞。

第一次工业革命发生在好几百年以前,瓦特改良蒸汽机;

第二次工业革命出现了电、汽车、石油;

第三次工业革命的前奏是个人电脑和互联网,而它的真正目的是AI。

我们正赶上这个时代正在来临的时刻,所以我称它为AI的黎明。

站在人类的角度上,这个世界正在发生10倍速的巨变,快到你根本不知道明天会发生什么。

但是令人遗憾的是,这场变革的上半场与中国人无关。

我们是旁观者,我们是学习者,我们是跟随者。

大家会无意识地想:让美国人去做原创吧,我去做应用和商业。

直到2025年1月20号,突然有一个人出现在新闻联播里,他就是梁文锋。

我相信在那一天之前,全世界全中国99.999999%的人都不知道他是谁。

那一天,梁文锋不仅参加了总理座谈会,同时带来了他震惊世界的发布——

"DeepSeek-R1"。

这是改变中国国运的一个AI支点。

DeepSeek的出现,一夜之间点燃了所有中国人对AI的热情,并且把低靡很久的创业激情又重新点燃了。

我想用混沌的创新四步法的前三步来分析DeepSeek:

第一步,建模型;

第二步,找单点;

第三步,找定位。

最后,我再把它跟OpenAI做一个对比。

Step1:建模型

诚恳地说,DeepSeek没有改变transformer的基础模型,而是在OpenAI的基础之上对大语言模型做了工程创新,大大的节省了成本,提高了效率。

DeepSeek玩的是一个有限的Scaling law。

首先,它没有那么多钱。

因为没有融资,用的是自己过去赚的利润的钱,因此它的资金很有限,不仅跟OpenAI相比非常有限,它跟中国领先的模型相比都是有限的。

其次,GPU受限。

因为美国人的卡脖子,GPU不是想买就能买,而且想买也只能买次等级别的GPU。

因此DeepSeek必须走低成本、高性能的路径。

有一个细节让我深受触动:梁文锋每次都会提醒他的工程师,这行代码能不能再省五毛钱的电费。

那么,DeepSeek到底是怎么做的呢?

我重点想讲另外两个在Transformer上的创新。

它在Transformer上的创新有两个关键词,一个是MLA(多头潜在注意力机制),一个是MoE(混合专家架构)。

我拿图书馆举例子,假如你是一名超级管理员,你需要记住图书馆所有的书,以及每一本书里面的每一个字,你想想看这个注意力机制需要的运算量有多大。

DeepSeek的创新之处在于:给每本书的每一页建立一个索引。

要查找内容的时候,先查书的索引,找到书后再查页的索引,然后把内容给用户。

这是非常精妙的做法。

因为如果有足够的资源可以一直找下去,没有资源的话就创造出了这个聪明的办法。

MoE一共有6700亿参数,而每次计算只需要激活37亿。

这样的结果是V3的模型的训练成本是557万美元,是同类模型成本的1/10。

对于DeepSeek来说,这就是有限的游戏。

其实有限游戏对创业者来说是机会,因为无限的游戏有时听到的不是信号,只是噪声。

2024年12月26号,DeepSeek 成功的发布了大语言模型V3,而且开源。

公允地说,DeepSeek的性能虽然还没有达到o1那么高,但它已经属于一流了。

它的立场是:我知道我跟你大概差不多,然后我开源出去。

这个气魄整个世界没有,而且成本只有其他竞争者的1/10。

但是真正让DeepSeek名震天下的,在所有人心里立住的不是V3,而是推理模型R1。

那从V3到R1到底发生了什么?怎么做到的?

GPT或者V3这样的大语言模型,需要依赖人类反馈的强化学习。

而R1不需要人类反馈,完全靠纯强化学习,也就是"左手打右手",因此,DeepSeek-R1名震天下。

OpenAI其实也在用"左手打右手"的方法,但他们从未公开算法。

DeepSeek的创新在于用了一种叫GRPO(群体相对策略优化)的算法——

先生成十个模型,淘汰掉一半差的,剩下的继续训练、淘汰,重复64轮后,最终模型就出来了。

OpenAI早期是开放的,连大语言模型的细节都会写论文公开,但到了GPT-4之后,他们就不再公开了,尤其是o1阶段,完全保密。

这部分工作DeepSeek没法直接抄,只能参考。

于是,他们用了一个全新的纯强化学习方法,也就是GRPO,训练出一个叫R1-zero的模型,解题效果特别好。

有意思的是,GRPO其实不是新技术,业内甚至认为它比OpenAI的PPO更落后,但DeepSeek用这个算法实现了低成本、高效率的效果。

关键区别在于优化方式——

OpenAI的PPO每一步推理都优化,过程精细但成本高。

DeepSeek没钱做精细优化,只能根据最终结果优化,中间的推理过程不管,只优化从问题到答案的整体效果。

所以DeepSeek做了一件特别重要的事:

它把所有的推理过程都公开了。你在DeepSeek里问任何问题,它都会把中间的推理过程展示给你。

这种交互方式震惊了全世界——

产品的本质就是交互模式。

过去模型只给答案,你无法判断对错;现在它连解题过程都告诉你,这非常厉害。

而OpenAI没这么做,是有苦衷的。

因为它的训练反馈花了巨额成本,高达几十亿甚至上百亿。一旦公开,别人可能直接拿这些数据蒸馏使用。

DeepSeek发布的第七天,英伟达的股价暴跌17%,当天市值蒸发了6000-7000亿美元。

原因是中国可以用相对便宜的芯片来构建如此强大的推理模型。

推理大模型相当于智能时代的核武器,而目前掌握这种核武器核心能力的只有中美两国。

而这件事情还是在一个名不见经传的、就在我们脚下的这片土地上的一家小公司完成的。

它没有出现在大厂,也没有出现在"六小虎"之中,而是出现在一个搞量化投资的人身上。

这件事情堪称国运级别的大事。

按照常理,这件事本不该发生。

无论从资金、GPU的资源、人才,还是社区储备来看,几乎什么条件都不具备,但它还是成功了。

当这件事完成时,意味着中国重新回到了人工智能的牌桌,甚至有可能开始坐庄。

Step2:找单点

使命

首先,我们探讨一个问题:DeepSeek的终极目标是什么?

DeepSeek的终极目标难道只是为了跑用户、直接商业化赚钱吗?

我认为并非如此。

DeepSeek可能是中国AI公司中唯一一个真正这样想的,甚至连OpenAI最初也有这样的想法,但后来却忘记了,那就是实现AGI(通用人工智能)。

AGI意味着在90%的领域中,AI能够超越90%的人,并且能够自主行动。

AGI正是让我们今天感到震惊,甚至恐惧的那个目标。

DeepSeek的终极目标并不是商业化,而是为人类、为全世界实现AGI。

如果它的目标是为全人类实现通用人工智能,那么DeepSeek的顾客是谁?

我想了很久,答案是:

全人类。

当我讲到马斯克的案例时,他想把人类移民到火星,我知道他的心中装着全人类。

当时我非常感慨,何时能在中国看到这样具有宏大世界观的企业家?

但梁文锋和DeepSeek的确是以全人类为目标,致力于实现通用人工智能。

如果要让全人类都能使用这种人工智能,那么顾客的真实需求是什么呢?如果用一个词来概括,那就是:足够便宜。极致低价才是王道。

用他们的话来说,就是"人人都能用得起的人工智能"。用一个时髦的词来形容,就是"普惠"。

我们认为,AI服务应该是人人都能负担得起且随时可用的。这就要求我们探索新的模型架构。我们必须在有限的资源下实现更强的能力普惠,这是需求所在。

如果想为全人类提供人人都能用得起的AI服务,应该选择什么路线呢?

这是一个基础的选择:开源还是闭源?

如果是闭源,仅靠自身服务所有人,显然是做不到的。

而如果是开源,我们可以只做基础及基座模型,让各个行业的人在此基础上开发行业模型或专有模型,再由它们为全人类提供服务。

核心能力

所以,不要只站在我们习惯的视角上纠结开源还是闭源。

要知道,OpenAI从一开始就想要做开源。

而梁文锋这位"商人中的商人",他从事金融,可以说是离钱最近的人,但他却在技术路线上选择了看似离钱最远的,开源。

梁文锋的选择是做开源,而且技术要领先。

这个想法可能看起来很奇怪。

为什么奇怪呢?

因为长期以来,我们的惯性思维是:美国人擅长原创式创新,处于领先地位;而中国人擅长跟随式创新,做从1到10的事情。

这种观念就像思想钢印一样,印在了三四代中国人的心中。

比如,一直以来,硅谷负责创新,中国人负责商业化。

所以硅谷的人也感到不满,每次他们创新,赚钱的却是我们,而我们也因此沾沾自喜。

但我们从未想过,我们也可以做0-1,从未想过这件事与中国有关。

整个业态几十年来一直是这样。

而且,做原创还有一个难题:全世界排名前50的AI人才几乎都在美国。

做这些事情需要人才,而排名前50的人才都在美国,我们还有什么希望呢?

这把我们逼到了绝境:我想为全人类提供一个开源的大模型,而且它要领先全世界,我不是跟随,那么,该怎么办呢?

这是在有限条件下的挑战。

最后,梁文锋说:"我不融资了,就用自己的钱来做这件事。"他一分钱也没融到。

他既没有钱,也没有这些顶级人才。

他原本也不在这个领域,但他却想超越美国,还要开源,那该怎么办呢?

他选择了一种独特的方式,去触发这种原创式的创新。

我相信,这一点是他成功的关键,至少是关键之一。

那个核心词汇就是"涌现"。

我还是那句话:如果今天有一个词你要带回去,我希望你把涌现带回去。

他用涌现式的组织来打造涌现式的AI,这是一个一体化的组织。

DeepSeek本质上是一家AI实验室,非盈利、不融资、不上市,而是一个学院式的实验室。

我突然发现,做出AI突破性进展的,其实都是AI实验室:

第一个是DeepMind,做出了阿尔法狗;

第二个是OpenAI,早期也是实验室,做出了GPT;

第三个就是DeepSeek,也是一个AI实验室。

AI实验室就是纯粹为一个理想而奋斗,先不考虑商业上的回报。

另一个特征是科学家和工程师放在一起,30%的人是研究员,70%的人是工程师。

工程师和科学家在一起工作,科学家有了想法后,工程师立刻就能将其付诸实践,反过来验证科学家的想法。

DeepSeek本身并没有那么多钱,但这种组织方式却让它获得了极大的优势。

开源

所以,DeepSeek的真实需求可能是普惠。而它的核心能力,我想可以用五个关键词来概括。

第一个关键词是"开源"。

如果选择开源,就必须创新;如果要创新,就必须有人才;而要让人才发挥作用,就必须依靠组织,组织的本质是一种交互模式。

最后,就是等待涌现,等待它的发生,静待花开。

梁文锋为什么选择开源?

他认为,在颠覆性技术领域,封闭式的护城河并不持久。

即使像OpenAI这样的闭源模式,也无法阻止其他公司迎头赶上。

因此,真正的护城河是团队的成长。

第一个关键词是"团队",第二个关键词是"团队的成长"。

团队成长

如何实现团队的成长呢?他强调,要培养创新的文化。

他说,"开源和发表论文不会带来重大损失。对技术人员来说,被同行追随本身就是一种成就感。开源不仅仅是一种商业策略,更是一种文化。回馈社区是一种荣誉,同时也能吸引更多优秀人才。"

此处所说的创新,专指从0到1的原创式创新,是技术创新,是基础研究的创新,而不是产品创新、商业创新或应用创新。

记者曾问梁文锋,为什么DeepSeek只专注于研究,而不像大多数中国公司那样同时布局大模型和应用。

梁文锋的回答代表了一种新的共识。

他说:"过去,人们普遍认为美国擅长创新,而中国擅长应用和落地。而我们认为,随着经济的发展,中国必须从技术的受益者转变为技术的贡献者,不能总是依赖别人的成果。"

这是一位年轻人的观点,代表着自觉兴起的一代新兴年轻人,他们由内而外地展现出一种自信,与上一代创业者背着巨大包袱负重前行的状态完全不同。

他们由内而外的自信,与上一代创业者截然不同。

在过去30年的IT革命中,我们几乎没有真正参与核心技术的革新,我们习惯了摩尔定律从天而降。

我们常说,只要等上18个月,即使现在这一级别我够不上,18个月后我就能用上今天的硬件和软件。

同样,在AI时代,面对大模型时,我们也相信摩尔定律。

每次OpenAI发布新成果,我们都说18个月后我们也能做到。

我们习惯了拿着盆来接别人过时的残渣来用。

当然,我们在商业、应用和产品上取得了成功,赚到了钱,但这样的成功对人类、对世界、对自己的生命和灵魂来说,是不够的。

而且,事实上,这些技术的进步是西方科技社区几代人持续努力的结果。

我希望大家能感受到的是,前后五代人孜孜不倦的努力,才有了OpenAI的奇迹。

过去,我们未能长期参与这一过程,反而逐渐忽视了它的真正价值。

我们会说,如果一个企业做基础研发,那是可笑的。

所以,过去30年,我们更注重利润而不是创新。但创新不仅仅是商业驱动的,它需要好奇心和有野心的创造力。我们被过去的习惯束缚住了。

我们习惯了别人做从0到1的创新,我们做从1到10、从10到100的拓展。

这个习惯成就了我们,也束缚了我们,让我们在创新方面似乎总是有一种羞耻感和缺乏勇气。

但这仅仅是个开始。

年轻人才

如果要进行原创创新,那么创新的核心关键词之一就是:

人才。

如今,寻找合适的人才并非易事,尤其是那些能够投身大模型创业的人才,他们极为稀缺。

有投资人指出,适合大模型创业的人才可能主要集中在OpenAI、谷歌等科技巨头的AI实验室中。

那么,我们会去海外挖掘这些人才吗?

梁文锋表示,"虽然全球前50名顶尖人才可能不在中国,但也许我们能自己打造这样的人。"

DeepSeek的人才团队完全由本土人才组成。

DeepSeek目前的成功最大程度归功于一支由年轻人组成的团队。他们年轻,技能多于经验,有应届毕业生和博士生,甚至在职博士生来组成。

梁文锋平时其实不太见人,他见的大多是前来面试的人。

曾有人在一个帖子中询问DeepSeek的工程师:"你为什么不去跳槽?"

工程师回答说:"我们老板亲自写代码,亲自撰写论文,还亲自参与面试。"

创新需要信心,而年轻人往往更具信心。

年轻人初生毛犊不怕虎,年轻人有信心,信心比经验重要100倍。

组织的本质:交互

那么,问题来了:这些初出茅庐的年轻人怎么可能干出一番事业呢?

所以下一个关键能力就是:

组织。

组织的本质是交互,组织就像一条河流,只要这个组织形成一个非常高频的"河流",普通人在这里也会产生共振,并随之成长起来。

所以,组织的本质是交互模式。

有人问过梁文锋:"你觉得在这波做大模型的竞争当中,创业公司更适合创新的组织架构,会不会成为大厂竞争的破局点呢?"

梁文锋说:"此前大公司的架构已经不适应快速响应了,而且他们过去的成功经验和惯性反而成为他们今天的束缚。在这波AI新浪潮之下,一定会有一波新公司诞生。"

你看移动互联网时代,有一批年轻人的公司起来了。

所以我坚定地相信:未来的AI时代,又会有一波新的创业公司出现,而不是像过去那些大公司继续站在这个舞台上。

就像你也知道对于大模型公司来说,算力是它最主要的成本。

但梁文锋说:"我们的计算资源对团队没有任何限制,但凡有任何人有想法都可以随时调用训练集群,无需批准。我们办公室设计中有会议室,两侧的门随时可以轻松打开。这种设计让'偶然相遇'成为可能。这让我想起Transformer的诞生——当时一位路过的研究员无意间听到讨论,帮助将其发展成了通用架构。"

这是一个涌现型组织。

涌现

其实,DeepSeek最重要的基础架构贡献,并非梁文锋本人想出来的,而是一个年轻的研究员某一天顿悟出来的。

你也可以说,这是一个集体涌现出来的至关重要的想法。

有限的资金、有限的算力、有限的人才,但我只相信一件事——

让人才和人才去交互。

如果AI通过交互能产生智能,我相信人和人通过交互也会碰撞出天才性的想法,这个过程就叫——

"涌现"。

再举一个例子,有一个年轻人叫王培懿,他是北大2020级的在读博士。2023年,他刚读到博士三年级就加入了DeepSeek。

他提到,去年加入DeepSeek时,自己没有任何强化学习的经验。

然而,在进行数学研究时,他独立推导出了一个统一公式,用于解决各种训练方法。

他说,这感觉就像是一个顿悟的时刻,仿佛这个组织突然被赋予了生命。

这个统一公式就是SFT(监督微调)公式。

强化学习的输出结果虽然正确,但它的语言表达方式可能是中文,也可能是英文,就像火星人发出的信号一样。

为了将其调整为人类能够接受的形式,他采用了监督微调。

监督微调是用人类的语言和表达习惯去调整模型的输出,使其更符合人类的理解方式。

这种监督学习是基于人类的反馈和机器的强化学习相结合的,通常是两个完全不相关的领域。

但这个年轻人居然用一个公式将它们融合在一起。

虽然我完全看不懂这个公式,相信大多数人也看不懂,但它仍然值得我们致敬。

这个公式是从R1-Zero回调到人类可接受的R1的关键一步,而它是由一个初出茅庐的年轻人完成的,而不是梁文锋。

DeepSeek-V2的论文有150多个作者,梁文锋的名字在中间。他甚至把数据标注人员的名字也写进了论文。

这不是靠天才,而是一群年轻人共同努力的结果。

当然,你也不要真的以为他们是普通的"生瓜蛋子":这些人智力超群,要么参加过奥数比赛,要么参加过物理竞赛,要么参加过计算机竞赛。

他们都是年轻的小天才,虽然没有经验,也没有成果,但梁文锋相信他们在一起可以做到。

我花了一个多月的时间去探究他们是怎么做到的,最后发现其实没有什么秘诀,只是相信人才,相信人才之间的交互,创新自然就会涌现出来。

这件事的意义,不仅在于激励了中国的大模型发展,更在于激励了中国的芯片公司。

我们或许也有机会在底层技术上实现一些创新。

这些年轻人如此自信、阳光,令人钦佩。

Step 3:找定位

屠龙少年

最后,让我们回到OpenAI身上。

OpenAI的创办,其实是一个屠龙少年终成恶龙的故事。

谷歌当时收购了DeepMind,这让马斯克等人非常警觉,因为大家都担心AI可能会毁灭人类,谁也不希望AI完全掌握在一个公司手里,哪怕这个公司是谷歌。

所以OpenAI的早期目标,是为了挑战谷歌的AI霸权。

正是在这样的目标感召下,意外地诞生了一个产品叫

ChatGPT。

它已经不仅仅是一项技术,而是一个具有用户交互的产品。

ChatGPT在5天内用户数突破百万,两个月内用户数过亿,成为史上增长最快的应用之一。

到今天为止,它的市场占有率也在一半以上。

此时OpenAI与谷歌之间的竞争态势会是什么样的呢?

回到我们熟悉的价值网络,错位竞争、低端颠覆,这些都是大家熟悉的策略。

你会发现有一个力量在背后起作用,叫"右上角迁移力",往往是边缘的打败主流的,这种"边缘必胜"的感觉。

我们回到这个案例中来看,也是如此。

谷歌收购了DeepMind,谷歌自己还有一个伟大的实验室叫Google Brain。谷歌发表了那篇震惊世界的Transformer论文,它又有钱又有用户,人才也在它那里。

按道理说,谷歌拥有无限资源,应该在AI领域胜出。

可惜谷歌无比赚钱,所以它的基因是一个面向消费者的互联网公司,就像印钞机一样赚钱。

OpenAI早期只是一个草台班子,甚至马斯克退出后,连工资都发不起了。

结果,万万没想到,OpenAI这个草台班子赢了,这是一个奇迹。

奇迹背后其实是有道理的,这个道理就是我们讲过很多遍的——

"创新者的窘境"。

既然Transformer是谷歌人最先提出来的,那么按道理,谷歌应该最先把产品做出来。

但是,当谷歌的人在内部讨论要不要把与大模型的交互产品化的时候,大多数部门都反对。第一,觉得它太低级了,还有很多幻觉,一本正经地胡说八道,怎么能发布这种玩具性的东西呢?第二,更重要的原因是ChatGPT出来之后,全世界哪一种产品最终会受损?——搜索。

如果推出这个产品,谷歌的主营业务搜索就会被干掉。

少年终成恶龙

原本一个恶龙垄断了所有的AI资源,然后一个少年怀着美好的愿望说——

"我要做这件事,而且我要开源,为了人类安全,保护全人类的AGI。"

我宁愿这样相信,让他赢。

但我们都知道这种故事往往会有下半场,少年自己会不会变成恶龙呢?

奥特曼战战兢兢地发布了ChatGPT。

ChatGPT的奥特曼,原来是硅谷最大的创业组织YC的创始人。

YC下面每年都有很多硅谷的创业公司。这些创业公司就是做产品、做应用,然后去融资、去上市的模式。

奥特曼本身不是技术人才,更不是研究人才,他是个创业者。

不过,在那之前,奥特曼也是一个理想主义者,是要做AGI的人。

但突然巨大的成功出来之后,让奥特曼看到了另一个世界。

他以为自己接手的是一家AGI实验室,弄清楚如何打造AI。

谁知道这是一家大型消费级互联网公司,而且是面向消费者的互联网公司,因为ChatGPT是个人在使用。

于是他转变了想法,几乎是彻底的转变,开始从非盈利向盈利转变——

2025年3月,融资400亿美元,估值3000亿美元。

3000亿美元是什么概念?就是超过了字节,仅次于SpaceX,是全世界第二大的未上市公司。累计融资600亿美元以上,也就是接近5000亿人民币。

2024年以后,OpenAI开始全面转向商业化,一个AI Lab的灵魂已经消失了,奥特曼今天讲未来的目标已经不是AGI,而是五年以后,要有几款几十亿用户的产品。

有人发现,OpenAI的官网已经将"Open"这个词删除了,这意味着他们不再强调开源的理念。

因为那个曾经充满理想主义的少年,他的初心似乎已经不复存在。

他似乎已经变成了另一个样子,甚至比谷歌更像谷歌。

最近,奥特曼在一次讲话中表现得更加现实。

他曾说,他原本以为OpenAI对社会的影响会比现在更大,但现在它只是一个强大的工具,而人们的生活基本上还是照旧。

对此,他表示自己其实很高兴,认为自己以前太天真了。

不知道为什么,我看到这段话,非常悲伤。

一个为人类开启未来窗口的人,自己却看不见那个世界了,他反而退回到那个世界里。

接棒少年的使命

我不知道各位是否和我一样,此刻感到一丝悲伤。

一个帮助整个人类开启天幕的人,在天幕刚刚开启的时候,不知道他是因恐惧而退缩,还是因利益而退回。

到今天为止,这家公司仍然遥遥领先全世界,但你会发现它的初心已经没有了。

所以,这家公司的顶级人才一直在往外走。

虽然公司还在,但它的灵魂好像越来越没有了。

下一个少年是谁呢?这个世界如果是美好的,总会有少年在。

我想也许就是梁文锋这个少年。

我想接下来这段梁文锋与记者的交锋,便是梁文锋在这个时候出现的意义。

记者问他:"什么叫AI信仰者?"

梁文锋说:"信仰者就是过去我在这儿,今天我还在这儿。不是因为今天大模型火爆我来到这儿,而是我过去一直在这儿,只是今天它恰巧火爆了。"

他在大学期间就开始研究人工智能,硕士论文是关于机器视觉的。

2010年硕士毕业后,他没有找工作,而是成为了一名自由职业者。

据说,他在成都一个简陋的出租房里待了几年,他在做什么呢?

他在寻找AI的应用场景。

最终,他找到了金融领域。

也就是说,他做金融并不是因为他原本就对金融感兴趣,而是金融是他切入AI的第一个领域。

因此,他用AI来做量化交易,而不是先做了量化交易,再引入AI技术。他凭借这种方法,从大约8万元的资金开始,赚到了8亿甚至更多。

后来,他成立了公司,叫幻方量化。

所有人都会说,这家公司不像是一家量化公司,更像是一家AI公司。

让我们看看这些年他到底在做什么——

2015年,他购买了100张GPU卡;

2019年,他搭建了一个名为"萤火一号"的计算机集群,拥有1000张卡,花费了两个亿;

2021年,他又搭建了"萤火二号",拥有1万张卡,花费十个亿;

2022年,美国政府对中国禁运高端芯片,但2021年梁文锋居然买了1万张卡;

2021年,中国只有五家公司拥有万张卡,其中完全不知名的就是这家公司。

那么,这个年轻人花钱去做AI,他是AI信仰者还是AI投机者呢?

你说今天他好像花了很多钱,他的基金总额也是300亿,你说他能赚多少钱?

他确实是用有限的资金,来做一件伟大的事情,那么他的使命到底是什么呢?

他说:"我们要做通用人工智能,AI人类智能的本质可能是语言,语言大模型是通往AI的必经之路。"

这是一个多么有定力的年轻人:目标很明确,不做垂类,不做应用,只做研究,只做探索。

各位透过纸面看一下,这是一个非典型的中国创业者——

因为几乎每一个中国创业者都是做垂类,都是做应用。阿里如此,腾讯如此,字节也是如此,六小虎全都是如此。

而他说:"我只做垂直大模型,我不做垂类,不做应用。"

无论如何,一个商业公司去做无限投入的研究性探索,都有些疯狂。

梁文锋说:"如果一定要找一个商业性理由,可能找不到,因为从商业角度来讲,基础研究就是投入回报比较低的。OpenAI早期投入资金的时候,想的一定不是我要拿回多少回报,而是真的想做这件事。现在比较确定的是,既然我们想做这件事,我们又有这个能力,在这个时间点上,我们就是最合适的人之一。"

这背后有一个低调当中的力量,叫做当仁不让:从最早的一张卡到2015年的100张,2019年的1000张,2021年的1万张。

很多人以为这里有一个商业逻辑,事实上他就是好奇心驱动的,在他商业最糟糕的那一年,所以,答案很明显:他做的事情就是为了好奇心。

好奇心是什么?是对AI边界的探索。

从2012年的AlexNet到2020年OpenAI发布GPT-3,虽然具体技术一直在变,但模型、算力和数据这三者的组合始终不变。

对于研究员来说,对算力的渴求是永无止境的:在做了小规模计算之后,总想做更大规模的实验。

换句话说,就是需要更多的算力和更多的卡。

这件事情是基于第一性原理推导出来的,是必须要做的事情。

所以,一个激动人心的事情或许不能单纯用金钱来衡量。

我想引用《三体》里的一个故事。

《三体》有一个隐喻叫"执剑人"。

如果三体人要毁灭地球,需要选一个执剑人来代表人类做决策的话,那么在AI时代或者AGI时代,要选一个执剑者,你会选谁呢?

我想有人会选奥特曼,因为他今天仍然遥遥领先;有人会选马斯克,因为他是对人类安危最关切的那个人。

但我相信,至少在历史上第一次,可以有一个中国人出现在为全世界、全人类服务的候选榜单里了。

最后,我们来对比OpenAI和DeepSeek。

OpenAI从开源变成了闭源,连论文都不发了,没人知道其模型的机理。

它开始变成一个消费互联网公司,to C和to B全都做。今天的核心主打产品是ChatGPT。

但与此同时,另一条路线出现了:开源,并且只做通用人工智能,面向开发者开源,只做基座大模型,让开发者在上面自由发挥,这是一个全新的选择。

这个选择面临两大难题。

第一大难题是技术上太难了;第二大难题是它不赚钱,站在今天的视角看,这条路看起来是不赚钱的。

所以,OpenAI才会从开源转向商业化。

你会发现,OpenAI空出来的这个生态位,被梁文锋和DeepSeek占据了。

今天,DeepSeek当仁不让地选择了那个少年"曾经走过但又离开的位置"。

当然,如果我今天问这里会不会发生生态位的迁移,我不知道,因为做这样的预测是很危险的。

但在我的内心深处,我希望这件事情发生。

OpenAI今天仍然遥遥领先,DeepSeek今天的创新更多是在工程上,而不是技术基架上的创新。

而且,OpenAI最近融了400亿美元,那是一个几乎无限的资金池。

再加上ChatGPT出来之后,美国对中国芯片的禁运又继续加强,梁文锋面前的压力更大了。

但我内心深处总会相信,坚持初心的人会赢。

为什么我说DeepSeek会赢?

我想很多人都忽略了一件事情,我相信梁文锋一定能同意:智能本身就是产品。它何尝不是智能时代的水、电、煤气,谁掌握了它,谁就是最赚钱的那一个。

我并不仅仅是出于民族情绪,因为有可能这个模型本身才是那个产品。着什么急呢?

就像你家小孩是天才,到了少年时期,你就说让他赶紧出去唱歌、卖唱赚钱,这不是毁了这个孩子吗?

我觉得人类对AI过于残忍了。

DeepSeek还没长大呢。

我坚信DeepSeek会为中国所有的AI应用把底层建好了。未来20年,我相信是AI应用的黄金20年。

这里我想再追问一个问题:为什么是DeepSeek做了这个原创,而不是大厂,不是字节、不是阿里、不是百度、不是腾讯?

是因为由于市值和估值的压力,大厂和六小虎都不得不迅速产品化和商业化。

就像腾讯,你说它有钱,但它不可能花上百亿美元去做基础大模型的研究,而不见商业回报。

所以,几十年来我们成于商业,但也困于商业。

他们不能做,也不敢做,这又是一个创新者的窘境。

但我认为更根本的原因:是两代中国创业者都不相信中国企业有能力做基础科研。

换句话说,在我们今天自己人在中国两代创业者的选项里,从未有过基础科研的选项。

这个选项,甚至都没有出现在我们的讨论话题里。

大家永远活在一个巨大的思想钢印里,认为美国人做原创,我们copy to China。你成于什么,就毁于什么。

这是一个巨大的思想钢印,让我们永远在后面追赶。

两代人的思想钢印,互联网一代、移动互联网一代,都在这个地方。

所以,梁文锋对中国创业的意义在于,他打破了新一代创业者的思想钢印和集体潜意识。

如果我们相信"转念就能改命",那么从这一刻开始,中国创业者、中国创新者的命运已经改变。

这便是为什么我认为:DeepSeek,是国运的AI支点。

最后,我想平复一下我的心情,说出最后一句话。

这句话送给我自己,送给各位,送给这个时代。

我想这句话是发自我内心的一句话,我以前还没有讲过这句话——

永远相信创业者

永远相信创新者

永远相信中国

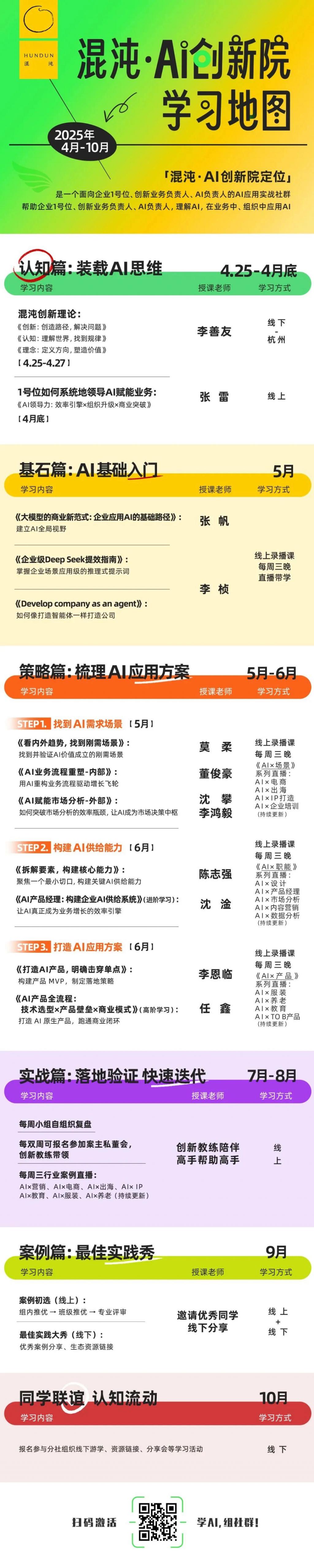

加入混沌·AI创新院,与AI业务1号位们并肩作战~这是一套混沌精心搭建的学习和服务体系,半年时间让你真正融入AI时代的浪潮中!

今晚24点截止报名

快来抢占AI时代的黄金席位!