蚂蚁百灵发布轻量级推理模型 Ring-mini-2.0, 将逐步全面开源

近日,据百灵大模型公众号,蚂蚁百灵团队发布并开源了Ring-mini-2.0推理模型。它是基于此前蚂蚁百灵发布的基础语言模型Ling2.0架构,深度优化的高性能推理型MoE模型。它在总参数量16B、仅激活1.4B参数的情况下,即可达到10B级别以下dense模型的综合推理能力,尤其在逻辑推理、代码与数学任务中表现卓越,并支持128K长上下文及300+token/s的高速生成。

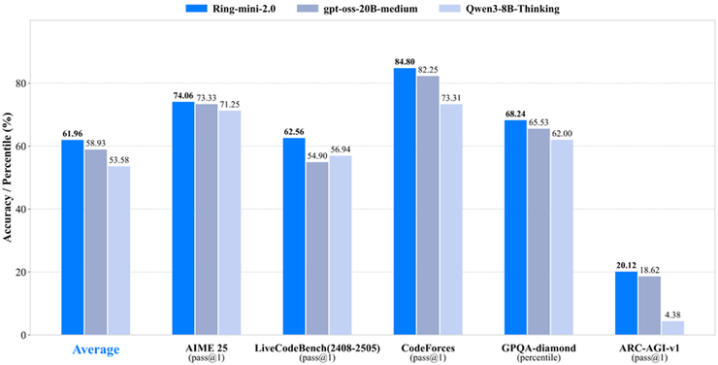

经过Long-COTSFT、更稳定持续的RLVR以及RLHF联合优化,Ring-mini-2.0复杂推理的稳定性与泛化性得到显著提升。在多项高难度基准(LiveCodeBench、AIME2025、GPQA、ARC-AGI-v1等)中,在输出长度相当的情况下,Ring-mini-2.0性能显著超越10B以下dense模型,甚至媲美更大参数量的MoE模型(如gpt-oss-20B-medium),在逻辑推理方面尤为突出。

(Ring-mini-2.0性能表现)

据了解,Ring-mini-2.0继承了Ling2.0系列的高效MoE设计,仅激活1.4B参数,通过1/32专家激活比、MTP层等架构优化,达到约7–8Bdense模型的等效性能。得益于小激活、高稀疏度的设计,Ring-mini-2.0在H20部署下实现300+token/s的吞吐,结合ExpertDualStreaming推理优化后可进一步提升至500+token/s,大幅降低高并发场景下Thinking模型的推理成本。同时,借助YaRN外推可支持128K长上下文,长输出场景下相对加速比最高可达7倍以上。

蚂蚁百灵团队表示将完整开放Ring-mini-2.0的模型权重、训练数据和RLVR+RLHF训练策略。凭借“小而优”的特点,Ring-mini-2.0有望成为小尺寸推理模型的首选,为学术和工业界提供理想的研究与应用起点。